Page 92 - Fister jr., Iztok, Andrej Brodnik, Matjaž Krnc and Iztok Fister (eds.). StuCoSReC. Proceedings of the 2019 6th Student Computer Science Research Conference. Koper: University of Primorska Press, 2019

P. 92

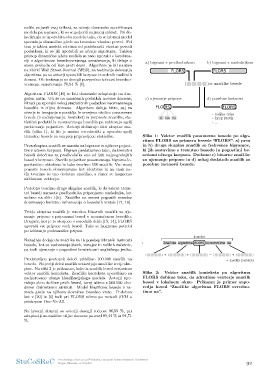

ilu pojavili vsaj trikrat, za uˇcenje domensko specifiˇcnega Slika 1: Vektor znaˇcilk posamezne besede po algo-

modela pa n-grame, ki so se pojavili najmanj enkrat. Pri de- ritmu FLORS na primeru besede “FLORS”. a) prva

kodiranju se uporabita oba modela tako, da se izbrani model in b) druga skupina znaˇcilk so frekvence bigramov,

spreminja dinamiˇcno glede na trenutno vhodno poved. Pri ki jih sestavimo s trenutno besedo in pogostimi be-

tem je izbira modela odvisna od podobnosti vhodne povedi sedami uˇcnega korpusa. Dodamo c) binarne znaˇcilke

podatkom, ki so jih uporabili za uˇcenje algoritma. Takˇsen za ujemanje pripone in d) nekaj dodatnih znaˇcilk za

pristop dinamiˇcne izbire modela se nato uporabi v kombina- posebne lastnosti besede.

ciji z algoritmom besednovrstnega oznaˇcevanja, ki deluje v

enem prehodu od leve proti desni. Algoritem je bil nauˇcen Slika 2: Vektor znaˇcilk konteksta po algoritmu

na zbirki Wall Street Journal (WSJ), za testiranje delovanja FLORS dobimo tako, da zdruˇzimo vektorje znaˇcilk

algoritma pa so avtorji uporabili korpuse iz sedmih razliˇcnih besed v lokalnem oknu. Prikazan je primer zapo-

domen. Ob testiranju so dosegli povpreˇcno toˇcnost besedno- redja besed “Znaˇcilke algoritma FLORS ovredno-

vrstnega oznaˇcevanja 70,54 % [6]. timo na”.

Algoritem FLORS [16] se loti domenske adaptacije na dru-

gaˇcen naˇcin. Uˇci se na oznaˇcenih podatkih izvorne domene,

hkrati pa uporabi nekaj statistiˇcnih podatkov neoznaˇcenega

besedila iz ciljne domene. Algoritem deluje hitro, saj za

uˇcenje in izvajanje uporablja le omejeno okolico posamezne

besede (v nadaljevanju: kontekst) in preproste znaˇcilke; sta-

tistiˇcni podatki iz neoznaˇcenega besedila pa zahtevajo zgolj

preˇstevanje pojavitev. Avtorji definirajo ˇstiri skupine zna-

ˇcilk (slika 1), ki jih je moˇzno ovrednotiti z uporabo zgolj

trenutne besede in vnaprej pripravljene statistike.

Prva skupina znaˇcilk se nanaˇsa na bigrame in njihove pojavi-

tve v uˇcnem korpusu. Bigram predstavimo tako, da trenutni

besedi doloˇcimo za predhodnika eno od 500 najpogostejˇsih

besed v korpusu. Sˇtevilo pojavitev posameznega bigrama lo-

garitmiˇcno obteˇzimo in tako tvorimo 500 znaˇcilk. Vse manj

pogoste besede obravnavamo kot identiˇcne in na enak na-

ˇcin tvorimo ˇse eno dodatno znaˇcilko, s ˇcimer se izognemo

niˇcelnemu vektorju.

Podobno tvorimo drugo skupino znaˇcilk, le da tokrat trenu-

tni besedi namesto predhodnika pripenjamo naslednika, kot

vidimo na sliki 1(b). Znaˇcilke na osnovi pogostih sosedov

doprinesejo koristno informacijo o besednih vrstah [17, 18].

Tretja skupina znaˇcilk je mnoˇzica binarnih znaˇcilk za uje-

manje pripone s priponami besed v neoznaˇcenem besedilu.

Drugaˇce, kot je to storjeno v sorodnih delih [19, 14], FLORS

uporabi vse pripone vseh besed. Tako se izognemo potrebi

po izbiranju podmnoˇzice pripon.

Nazadnje dodajo ˇse znaˇcilke za 16 posebej izbranih lastnosti

besede, kot so vsebovanje ˇstevk, vezajev in velikih zaˇcetnic,

pa tudi ujemanje s pogostimi konˇcnicami angleˇskega jezika.

Predstavljen postopek doloˇci pribliˇzno 100.000 znaˇcilk na

besedo. Najveˇcji deleˇz znaˇcilk sestavljajo znaˇcilke tretje sku-

pine. Na sliki 2 je prikazano, kako iz znaˇcilk besed sestavimo

vektor znaˇcilk konteksta. Znaˇcilke konteksta uporabimo za

nadzorovano uˇcenje klasifikacijskega modela. Avtorji upo-

rabijo okno dolˇzine petih besed, torej uˇcimo s 500.000 vho-

dnimi diskretnimi atributi. Model klasificira besede v ra-

zrede glede na njihovo slovniˇcno besedno vrsto. Podobno

kot v [20] in [6] tudi pri FLORS uˇcimo po metodi SVM s

pristopom One-Vs-All.

Na izvorni domeni so avtorji dosegli toˇcnost 96,59 %, pri

adaptaciji na razliˇcne ciljne domene pa med 89,44 % in 94,71

%.

StuCoSReC Proceedings of the 2019 6th Student Computer Science Research Conference 92

Koper, Slovenia, 10 October

modela pa n-grame, ki so se pojavili najmanj enkrat. Pri de- ritmu FLORS na primeru besede “FLORS”. a) prva

kodiranju se uporabita oba modela tako, da se izbrani model in b) druga skupina znaˇcilk so frekvence bigramov,

spreminja dinamiˇcno glede na trenutno vhodno poved. Pri ki jih sestavimo s trenutno besedo in pogostimi be-

tem je izbira modela odvisna od podobnosti vhodne povedi sedami uˇcnega korpusa. Dodamo c) binarne znaˇcilke

podatkom, ki so jih uporabili za uˇcenje algoritma. Takˇsen za ujemanje pripone in d) nekaj dodatnih znaˇcilk za

pristop dinamiˇcne izbire modela se nato uporabi v kombina- posebne lastnosti besede.

ciji z algoritmom besednovrstnega oznaˇcevanja, ki deluje v

enem prehodu od leve proti desni. Algoritem je bil nauˇcen Slika 2: Vektor znaˇcilk konteksta po algoritmu

na zbirki Wall Street Journal (WSJ), za testiranje delovanja FLORS dobimo tako, da zdruˇzimo vektorje znaˇcilk

algoritma pa so avtorji uporabili korpuse iz sedmih razliˇcnih besed v lokalnem oknu. Prikazan je primer zapo-

domen. Ob testiranju so dosegli povpreˇcno toˇcnost besedno- redja besed “Znaˇcilke algoritma FLORS ovredno-

vrstnega oznaˇcevanja 70,54 % [6]. timo na”.

Algoritem FLORS [16] se loti domenske adaptacije na dru-

gaˇcen naˇcin. Uˇci se na oznaˇcenih podatkih izvorne domene,

hkrati pa uporabi nekaj statistiˇcnih podatkov neoznaˇcenega

besedila iz ciljne domene. Algoritem deluje hitro, saj za

uˇcenje in izvajanje uporablja le omejeno okolico posamezne

besede (v nadaljevanju: kontekst) in preproste znaˇcilke; sta-

tistiˇcni podatki iz neoznaˇcenega besedila pa zahtevajo zgolj

preˇstevanje pojavitev. Avtorji definirajo ˇstiri skupine zna-

ˇcilk (slika 1), ki jih je moˇzno ovrednotiti z uporabo zgolj

trenutne besede in vnaprej pripravljene statistike.

Prva skupina znaˇcilk se nanaˇsa na bigrame in njihove pojavi-

tve v uˇcnem korpusu. Bigram predstavimo tako, da trenutni

besedi doloˇcimo za predhodnika eno od 500 najpogostejˇsih

besed v korpusu. Sˇtevilo pojavitev posameznega bigrama lo-

garitmiˇcno obteˇzimo in tako tvorimo 500 znaˇcilk. Vse manj

pogoste besede obravnavamo kot identiˇcne in na enak na-

ˇcin tvorimo ˇse eno dodatno znaˇcilko, s ˇcimer se izognemo

niˇcelnemu vektorju.

Podobno tvorimo drugo skupino znaˇcilk, le da tokrat trenu-

tni besedi namesto predhodnika pripenjamo naslednika, kot

vidimo na sliki 1(b). Znaˇcilke na osnovi pogostih sosedov

doprinesejo koristno informacijo o besednih vrstah [17, 18].

Tretja skupina znaˇcilk je mnoˇzica binarnih znaˇcilk za uje-

manje pripone s priponami besed v neoznaˇcenem besedilu.

Drugaˇce, kot je to storjeno v sorodnih delih [19, 14], FLORS

uporabi vse pripone vseh besed. Tako se izognemo potrebi

po izbiranju podmnoˇzice pripon.

Nazadnje dodajo ˇse znaˇcilke za 16 posebej izbranih lastnosti

besede, kot so vsebovanje ˇstevk, vezajev in velikih zaˇcetnic,

pa tudi ujemanje s pogostimi konˇcnicami angleˇskega jezika.

Predstavljen postopek doloˇci pribliˇzno 100.000 znaˇcilk na

besedo. Najveˇcji deleˇz znaˇcilk sestavljajo znaˇcilke tretje sku-

pine. Na sliki 2 je prikazano, kako iz znaˇcilk besed sestavimo

vektor znaˇcilk konteksta. Znaˇcilke konteksta uporabimo za

nadzorovano uˇcenje klasifikacijskega modela. Avtorji upo-

rabijo okno dolˇzine petih besed, torej uˇcimo s 500.000 vho-

dnimi diskretnimi atributi. Model klasificira besede v ra-

zrede glede na njihovo slovniˇcno besedno vrsto. Podobno

kot v [20] in [6] tudi pri FLORS uˇcimo po metodi SVM s

pristopom One-Vs-All.

Na izvorni domeni so avtorji dosegli toˇcnost 96,59 %, pri

adaptaciji na razliˇcne ciljne domene pa med 89,44 % in 94,71

%.

StuCoSReC Proceedings of the 2019 6th Student Computer Science Research Conference 92

Koper, Slovenia, 10 October